Die richtigen NCache in RedHat OpenShift

Kubernetes-Cluster, Docker und Linux

Red Hat Enterprise Linux. Sie können dies sowohl für Java als auch für .NET Core um weitere Anwendungsbeispiele zu finden.

OpenShift ist eine Open-Source-Container-Anwendungsplattform von Red Hat, die auf dem Kubernetes-Container-Orchestrator für die Entwicklung und Bereitstellung von Unternehmensanwendungen basiert.

Wenn Ihre Anwendung Java ist und/oder .NET Core läuft auf Red Hat Enterprise Linux und OpenShift und Sie verwenden möchten NCache um seine Leistung und Skalierbarkeit für Spitzentransaktionslasten zu verbessern, dann seien Sie bitte versichert NCache unterstützt dieses Umfeld voll und ganz.

Sehen Sie sich dieses Video an, um zu sehen, wie einfach die Bereitstellung ist NCache als Teil Ihres Red Hat OpenShift Kubernetes-Clusters als Docker-Bereitstellung.

Heute werde ich zeigen, wie Sie es verwenden können NCache in der Containerplattform Red Hat OpenShift. Wie Sie wissen, ist OpenShift eine Container-Plattform, die von Red Hat angeboten wird und auf Anwendungscontainern basiert, die von Docker betrieben werden, während die Orchestrierungs- und Verwaltungsdienste von Kubernetes bereitgestellt werden.

Es basiert auf Red Hat Enterprise Linux und heute zeige ich Ihnen Schritt-für-Schritt-Details für die Bereitstellung und Verwendung von NCache auf dieser Plattform. Fangen wir also schnell damit an.

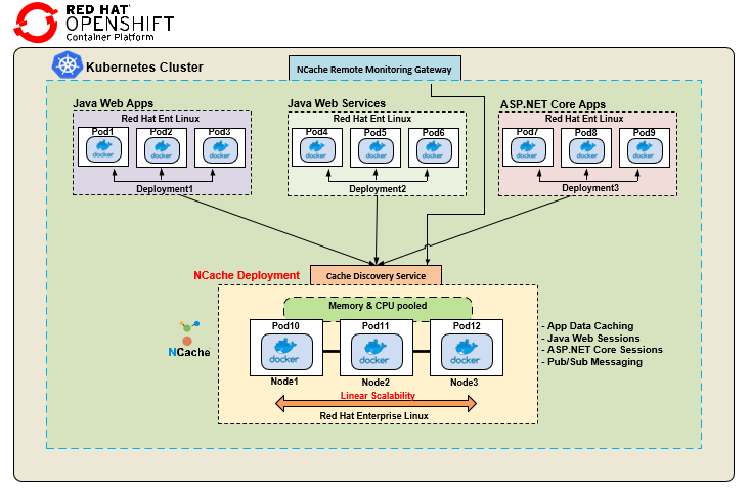

NCache Einsatz

Lassen Sie uns zunächst überprüfen NCache Bereitstellung auf der Containerplattform Red Hat OpenShift. Hier ist eine typische Bereitstellung von NCache in der Containerplattform Red Hat OpenShift. Ich zeige einen einzelnen Kubernetes-Cluster mit verschiedenen Anwendungsbereitstellungen sowie NCache Cluster-Bereitstellung.

Wir haben eine Java-Web-App, die wiederum ein Docker-Image ist, das auf verschiedenen Pods bereitgestellt wird. Ich habe einen Java Web Service wieder von verschiedenen Pods angezeigt. Diese Java-Anwendungen verwenden den Java-Client von NCache, während ich eine separate Bereitstellung für ASP habe.NET Core Anwendungen, die wiederum ein Docker-Image unter Linux verwenden, aber dies verwendet die .NET Core Kunde für NCache Kommunikation. Was die serverseitige Bereitstellung betrifft, verwendet es Linux-basiertes Docker-Image für NCache, das auf unserer Website verfügbar ist, und Sie wissen, Sie können es unter Red Hat Enterprise Linux verwenden, wie hier gezeigt, und Sie wissen, Sie erstellen einen Cache-Cluster mit verschiedenen Docker NCache Bilder, die auf dieser Plattform zur Verfügung gestellt werden, und dann habe ich diese Cache-Erkennungsdienst und NCache Fernüberwachungs-Gateway.

Dieser Erkennungsdienst ist also ein kopfloser Dienst in Kubernetes, den Sie in OpenShift erstellen können, und ermöglicht es allen Ihnen bekannten Clientanwendungen, sich einfach mit sich selbst zu verbinden, und dann würde dies das Routing und die Erkennung zu allen Ressourcen verwalten, die Teil von sind Cache-Cluster. Zum Beispiel muss ich die IP-Adressen oder Details zu Pod 10, 11 oder 12 nicht kennen, ich verbinde mich einfach mit diesem Discovery Service, der ein Named Service ist und der mich wiederum zu allen weiterleiten würde Ressourcen darin NCache Cache-Cluster. In ähnlicher Weise stellt auch ein Remote Monitoring Gateway eine Verbindung zu diesem Discovery Service her, damit Überwachungs- und Verwaltungsvorgänge außerhalb dieses Kubernetes-Clusters von beliebigen Systemadministratoren durchgeführt werden können, und ich werde Ihnen eine praktische Demonstration dieser beiden geben, wie Sie diese tatsächlich erstellen . Dies ist also eine typische Bereitstellung, bei der verschiedene Arten von Anwendungen eine Verbindung herstellen NCache in einem einzelnen Kubernetes-Cluster.

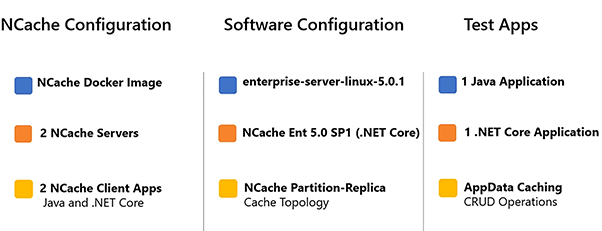

Hier finden Sie Details zur Einrichtung unserer Demoumgebung.

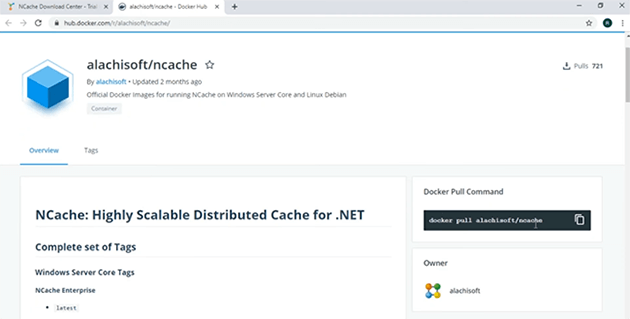

Ich verwende 2 NCache Server, um einen Cluster zu formulieren, und ich werde 2 Client-Anwendungen verwenden, um eine Verbindung zu diesem Cache herzustellen. Die Serverseite NCache Das Docker-Image wird mit diesem Tag „enterprise-server-linux-5.0.1“ dargestellt.

Dies ist sowohl auf unserer Website als auch auf verfügbar Docker-Hub. Es ist unsere neueste Version 5.0 SP1 .NET Core Version, so dass Sie es sowohl unter Windows als auch unter Linux verwenden können, aber für diese Demonstration verwenden wir Linux. Die Java-Anwendung verwendet den Java-Client von NCache und .NET Core Anwendung wird verwendet .NET Core Auftraggeber von NCache und ich benutze CRUD-Operationen um den Anwendungsfall des App Data Caching innerhalb dieser Anwendungen darzustellen.

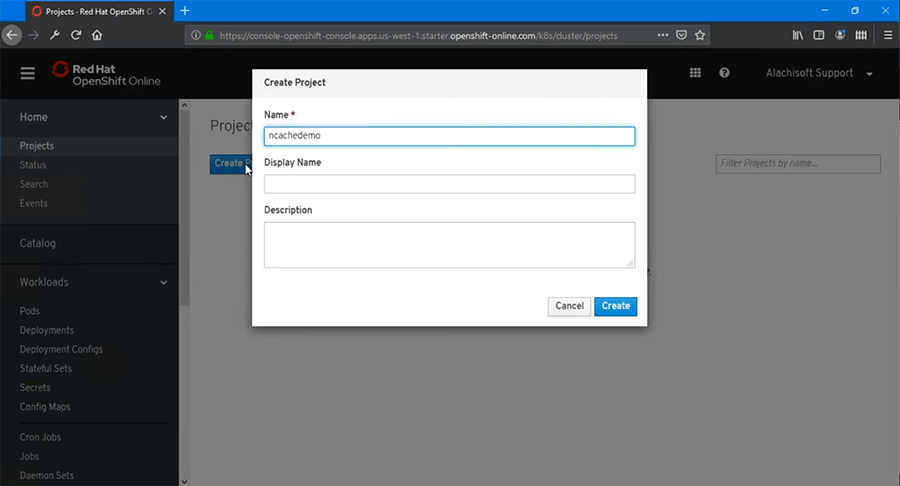

Deploy NCache Fertige Server

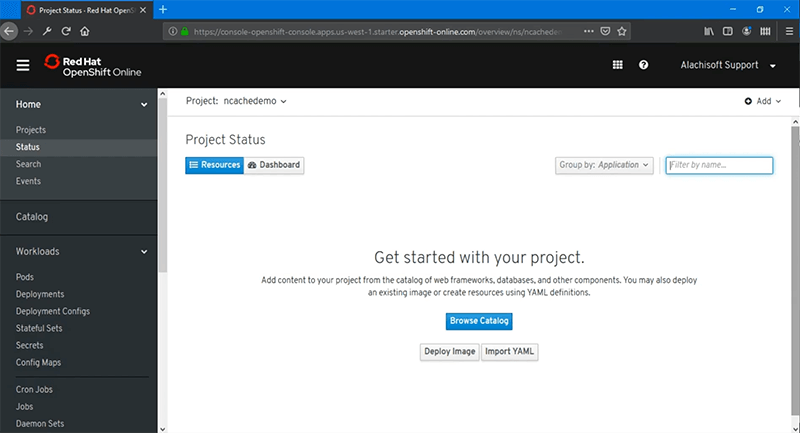

Der erste Schritt ist die Bereitstellung NCache Server in OpenShift. Fangen wir also schnell damit an. Ich bin bei der Red Hat OpenShift-Webkonsole angemeldet und als erstes müssen wir ein Projekt erstellen.

Erstellen wir also ein leeres Projekt. Nennen wir es 'ncachedemo' und wählen Sie 'Erstellen' und danach erstellen wir einfach ein leeres Projekt.

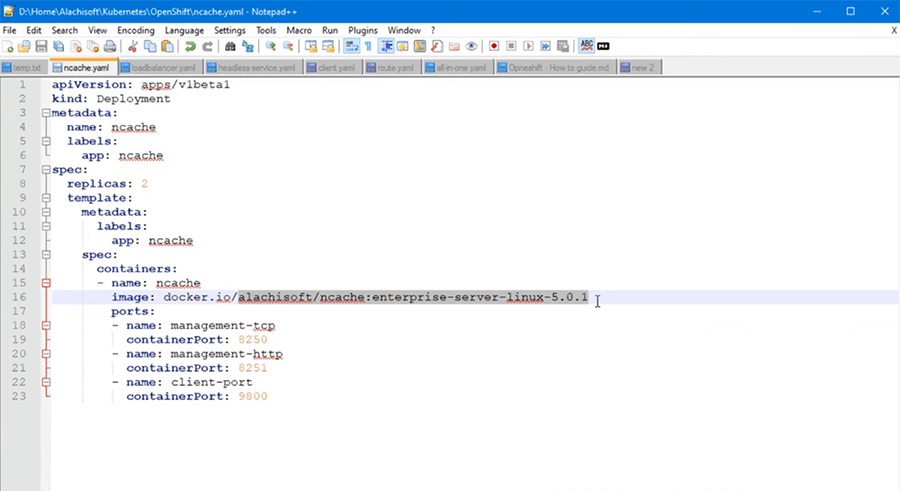

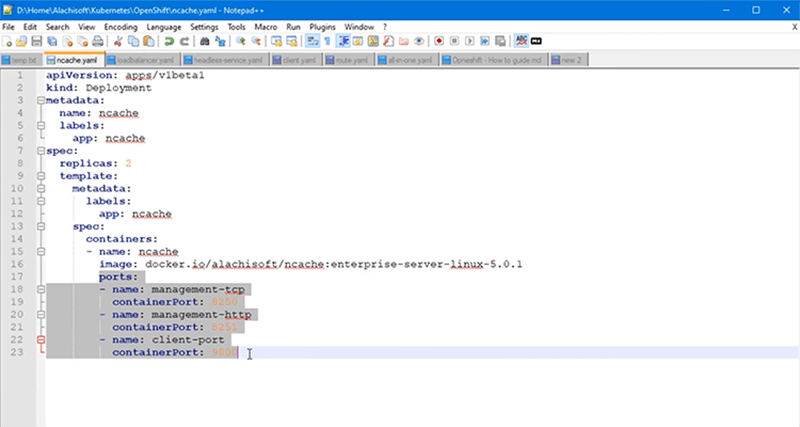

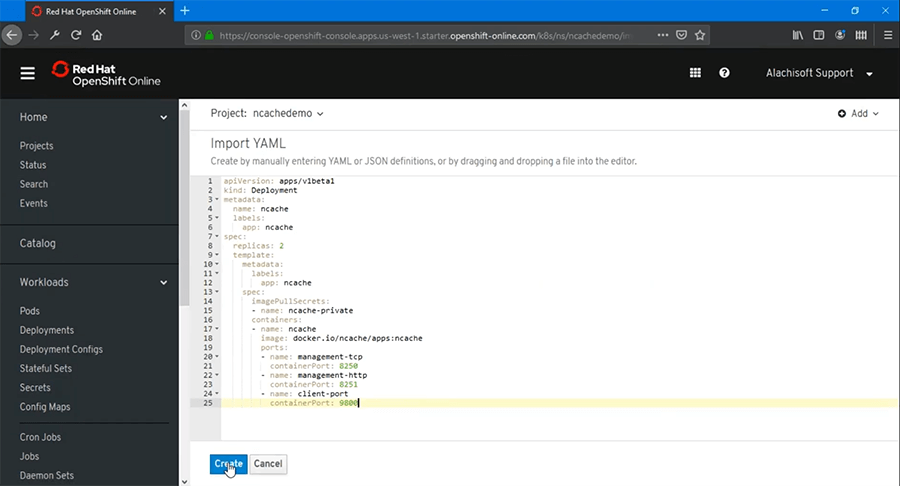

Zu diesem Zeitpunkt gibt es keine Bereitstellungen. Also müssen wir mit der Bereitstellung von beginnen NCache Server und dafür kann ich den Katalog durchsuchen oder ich kann eine vorkonfigurierte YAML-Datei verwenden, die Sie bereits für Anwendungsfälle für die Produktion haben sollten, und Sie können diese YAML-Datei importieren. Also, lassen Sie uns das tatsächlich tun und ich habe bereits eine YAML-Datei, die ich verwenden würde NCache serverseitige Bereitstellung. Hier ist es. Es ist also der Bereitstellungstyp richtig, die „Art“ ist „Bereitstellung“, „Name“ ist ausgewählt als „ncache'. Ich werde zwei Replicas verwenden und dann habe ich hier einige Container-Image-Details. Das Wichtigste, was ich hervorheben möchte, ist also das Docker-Image, das ich hier verwende.

Das ist NCache Enterprise Server-Linux-Docker-Image, das auf Docker Hub verfügbar ist, und Sie können auch eine Referenz dazu von unserem erhalten Download-Seite auch. Also, wenn Sie gehen NCache Auf der Download-Seite sollten Sie dieses Bild hier sehen können. Das Cache-Server-Linux-Image, das auf Docker Hub verfügbar ist. Wenn ich darauf klicke, würde ich direkt dorthin gelangen Docker-Hub und von dort können Sie dieses Bild ziehen. Es gibt also einen allgemeinen Pull-Befehl ‚docker pull alachisoft/ncache' und das Tag, nach dem wir speziell suchen, ist Enterprise Server Linux 5.0.1, und das ist unser Main .NET Core Linux-Version, die wir für diese Demonstration verwenden werden.

Als nächstes ist die Anzahl der Replikate, die die Anzahl der Ports definiert, es werden 2 sein und dies sind Details zu allen Ports, die ich für meine verwende NCache Behälter, die ich mindestens öffnen muss.

Dies sind Verwaltungs- und Client-Verbindungsports für NCache Kommunikation. Ich habe also diese YAML-Datei, die ich importieren und dann auf „Erstellen“ klicken würde, und das würde automatisch, wie Sie wissen, meine Bereitstellung starten NCache Servers

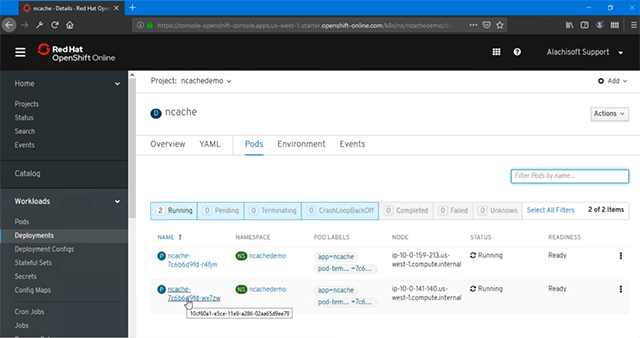

Wie Sie bereits sehen können, habe ich in Deployments 'ncache'-Bereitstellung und ich habe '2 Pods', die erstellt werden, und ich kann den Status dieser Pods weiter sehen, ob sie ausgeführt werden oder nicht, indem ich auf die 'Pods' klicke, und danach sollte mir der aktuelle Status angezeigt werden zeigt sie laufen und sie sind auch bereit.

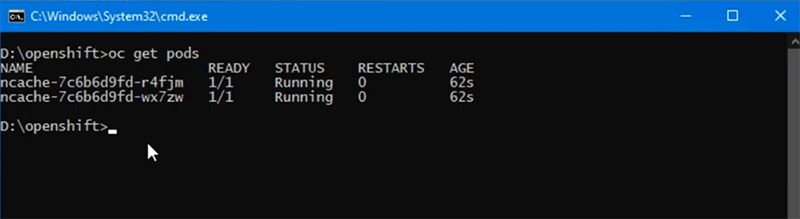

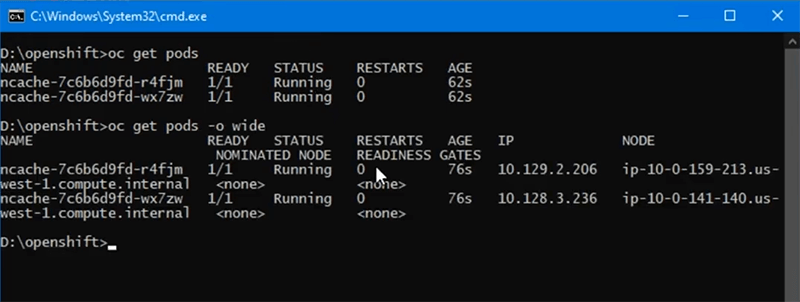

Es gibt also zwei Bereitstellungen von NCache die zur Verfügung gestellt werden. Übrigens, all dies kann wie jetzt gezeigt über die Webkonsole erfolgen, oder Sie können auch die Befehlszeilentools ausführen, um den Status Ihrer laufenden Pods weiter anzuzeigen, und dafür müssen Sie den Befehl ausführen 'oc get pods' und das listet alle Pods auf, die genau hier bereitgestellt werden, und Sie können die Namen auch abgleichen, „r4f“ und „wx7“ sind die gleichen Pods, die wir gerade erstellt haben.

Wenn ich weiter die IP-Adressen sehen will, kann ich das auch verwenden 'Schoten bekommen -o breit' switch und das würde mir auch weitere Details zu den IPs dieser Pods geben. Wir haben also .206 und .236 als zwei Pods, die mit laufen NCache Server-Image, das auf ihnen bereitgestellt wird.

Cache-Erkennungsdienst

Wir werden einen Cache-Discovery-Service erstellen, der uns dabei hilft, alle zu routen NCache Kommunikation mit zugrunde liegenden Pods und dies wurde auch als Teil unserer Bereitstellung besprochen, wo wir einen Headless-Dienst hatten, um die gesamte Client-zu-Server-Kommunikation zu verwalten NCache und wir werden dies auch für Verwaltungs- und Überwachungsoptionen für diesen Cache-Cluster und auch außerhalb des Kubernetes-Clusters verwenden, den wir haben.

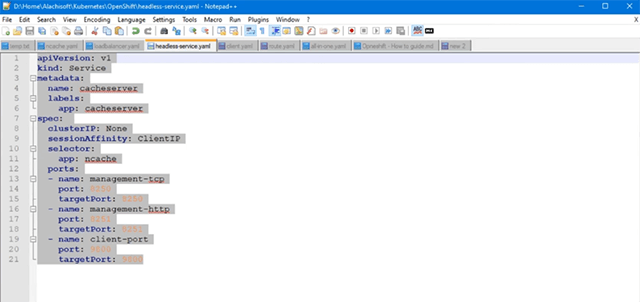

Sehen wir uns also an, wie dieser Cache-Erkennungsdienst erstellt wird. Jetzt um die zu erstellen Cache-Erkennungsdienst, wir brauchen wieder eine YAML-Datei, die ich hier habe und wenn wir den Inhalt dieses Dienstes durchgehen müssen, ist es der Typ 'Service', ich habe ihn 'Cacheserver' genannt. Sie können sich einen beliebigen Namen ausdenken. SessionAffinity muss auf 'ClientIP' gesetzt werden. Dadurch soll sichergestellt werden, dass die Verwaltungs- und Überwachungsvorgänge außerhalb des Kubernetes-Clusters zu jedem Zeitpunkt an einem der Pods hängen bleiben. Das ist also ein obligatorischer Schritt, den Sie einrichten müssen, und dann hat er einfach eine Zuordnung von diesem benannten Dienst zu den zugrunde liegenden Pods. Zum Beispiel haben wir den Port 8250 von Service 2 Pods zugeordnet und die von mir gewählte Bereitstellung ist NCache das würde also alles abdecken NCache Pods, die wir bereits bereitgestellt haben, und dann haben wir 8251 und dann Port 9800. Die ersten beiden Ports sind also für Verwaltungs- und Überwachungsoptionen und Port 9800 ist für die Client-zu-Server-Kommunikation zwischen den Clientanwendungen, mit denen eine Verbindung hergestellt wird NCache.

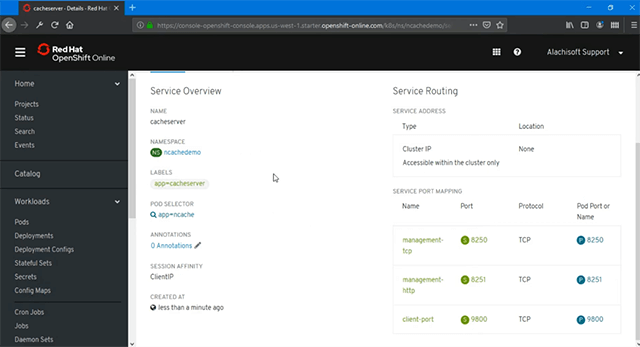

Okay, jetzt importieren wir diese YAML-Datei über unseren Assistenten, und danach würde ich auf „Hinzufügen“ klicken, auf „Erstellen“ klicken und dies würde automatisch meinen Cache-Erkennungsdienst erstellen. Wie Sie sehen können, ist der 'POD SELECTOR' 'ncache'. Das ist also für NCache Pods und Service to Port Mapping deuten darauf hin, dass wir 8250, 8251 und 9800 erfolgreich zwischen unserem Cache-Erkennungsdienst und allen zugeordnet haben NCache Schoten. Damit ist die Einrichtung des Cache-Erkennungsdienstes hier abgeschlossen.

Management-Gateway erstellen

Der nächste Schritt besteht darin, ein Verwaltungs- und Überwachungsgateway für zu erstellen NCache Bereitstellungen und das würde es uns ermöglichen, zu verwalten und zu überwachen NCache Bereitstellungen außerhalb dieses Kubernetes-Clusters und die Funktionsweise wäre, dass alle durchgeführten Verwaltungsvorgänge über dieses Gateway zu diesem Cache-Erkennungsdienst geleitet würden, was Ihnen wiederum dabei helfen würde, alle zugrunde liegenden Pods zu verwalten und zu überwachen.

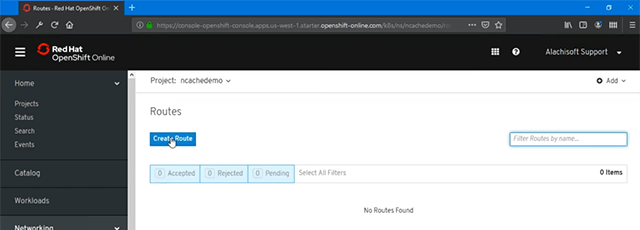

Sehen wir uns also an, wie Sie dieses Gateway schnell einrichten können. Um jetzt das Management Gateway zu erstellen, muss ich unter „Networking“ gehen und dort haben wir „Routes“.

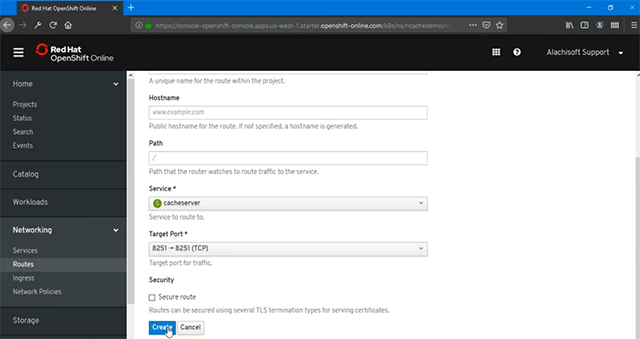

Also werde ich einfach weitermachen und unsere Route zu diesem kopflosen Dienst erstellen. Wenn ich also darauf klicke, können Sie ihm einfach einen beliebigen Namen geben und basierend darauf müssen Sie nur den Dienst auswählen, und in diesem Fall muss der im vorherigen Schritt erstellte Dienst „Cacheserver“ ausgewählt werden. Es würde hier nur alle Dienste auflisten und Sie müssen nur den Zielport für Management und Monitoring angeben.

An diesem Punkt werde ich einfach 8251 verwenden und auf „Erstellen“ klicken, denn das ist derjenige, der es mir ermöglichen würde, zu erstellen, Sie wissen schon, zu verwalten und zu überwachen NCache auch außerhalb dieses Kubernetes-Clusters, und dies ist der Ort, von dem aus ich einfach klicken kann, und das würde automatisch die öffnen NCache Webverwaltungszugriff auf einen der darin enthaltenen Pods NCache Bereitstellung und wie Sie sehen können, habe ich .3.236 IP angezeigt.

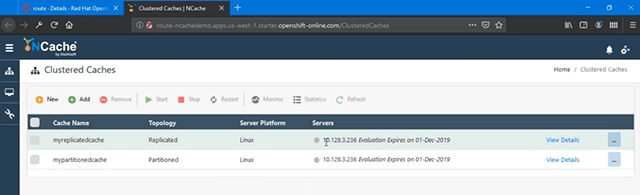

Dies sind einige vorkonfigurierte Caches, und wenn Sie bemerken, ist dies einer der Pods aus meiner Bereitstellung, mit denen ich verbunden wurde. Ich kann also vollständig auf den zugrunde liegenden Pod zugreifen und sie verwalten. Eine Sache, die ich hier zeigen möchte, ist der Session-Affinitätsaspekt, das ist ein obligatorischer Schritt. Dies soll wiederum sicherstellen, dass Sie beim Öffnen eines Pods zu Verwaltungszwecken klebrig sein müssen. Die Verwaltungsbefehle müssen an dieses Pod-Recht gebunden sein. Dazu müssen Sie diesen Wert also auf „ClientIP“ setzen, und dies ist einer der obligatorischen Schritte, die Sie einrichten müssen.

Wenn ich dies durchgegangen bin, kann ich deutlich sehen, dass ich mit .236 verbunden bin, wenn ich auf das Verwaltungsportal zurückkomme, und von hier aus kann ich alle Arten von Verwaltungs- und Überwachungsvorgängen für durchführen NCache.

Cache-Cluster erstellen

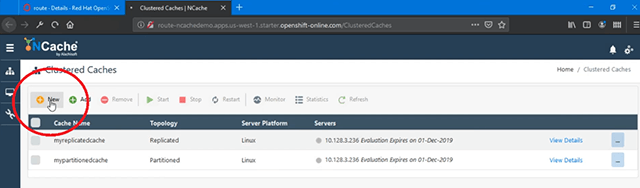

An dieser Stelle wird unsere OpenShift-Umgebung eingerichtet für NCache ist abgeschlossen und wir können jetzt fortfahren und als Nächstes einen Cache-Cluster erstellen. Okay, in diesem Verwaltungstool klicke ich auf „Neu“ und das öffnet einen Cache-Erstellungsassistenten für mich.

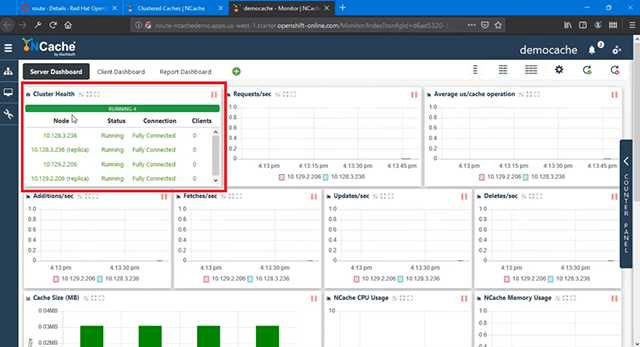

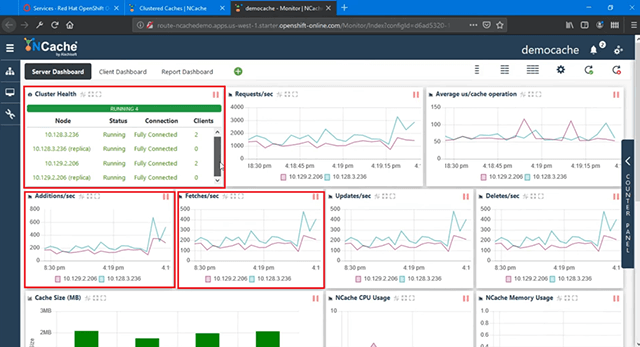

Ich werde meinen Cache nennen, nennen wir ihn 'Democache'. Ich behalte hier alles als Standard, 'Partition of Replica' und gebe die erste IP an, die automatisch vergeben wird, und ich brauche die IP des zweiten Pods, die ich von hier kopieren und dann hier einfügen kann, und wähle dann diese aus, klicke darauf Pluszeichen (+) und das würde den zweiten Pod angeben. Behalten Sie auch hier wieder alles als Standard bei. Die Parameter sind gleich und dann 'Starte diesen Cache beim Beenden' und wähle 'Fertig stellen' und das würde fortfahren und meinen Cache-Cluster erstellen. Mit diesen beiden Pods verwenden Sie also die NCache Web Management Tool kann ich jetzt einen Cache-Cluster erstellen und den Web Manager direkt hier aus meiner eigenen Box verwenden. Wenn ich hier auf Details klicke, kann ich auch einige weitere Details zu Überwachungsaspekten sehen und ich kann auch die Statistiken dieses Cache-Clusters sehen. Sobald es geladen wird, können Sie also sehen, dass es verschiedene Parameter gibt. Wir können „Cluster Health“ sehen, das vollständig verbunden ist, und wir können hier auch einige andere Diagramme sehen.

Zu diesem Zeitpunkt ist kein Client verbunden, daher sehe ich keine Clientprozesse oder Clients, die im Clusterzustand angezeigt werden, aber sobald ich meine Clientanwendungen bereitstellen und ausführen würde, würde ich tatsächlich Clientprozesse sehen, sobald sie verbunden mit NCache hier unten, sowie auf der anderen Seite auch. Unser NCache Cache-Cluster wird erstellt und kann verwendet werden.

Bereitstellen und Ausführen von Client-Anwendungen

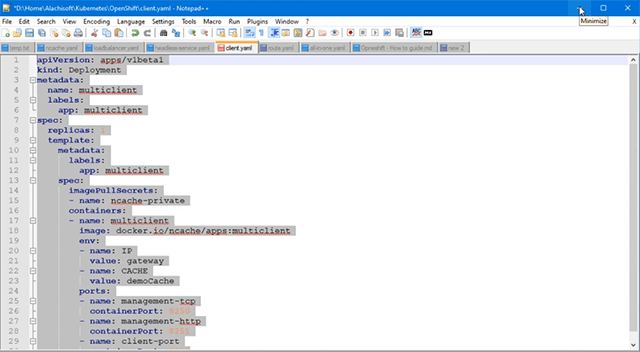

Der nächste Schritt besteht darin, Clientanwendungen in OpenShift bereitzustellen und auszuführen, die diesen Cache-Cluster verwenden. Auch hier werde ich die YAML-Datei für die Client-Bereitstellung laden, und hier haben wir sie, wo wir eine Bezeichnung als „Multiclient“ haben und es sich wieder um eine separate Bereitstellung handelt.

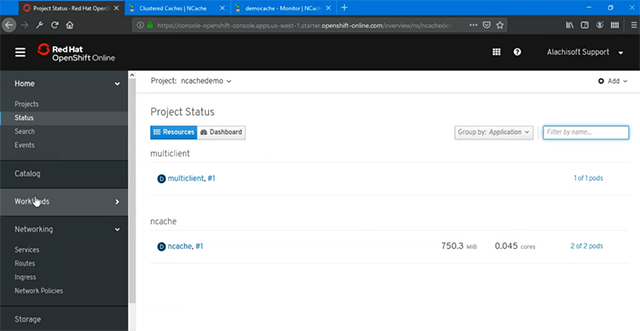

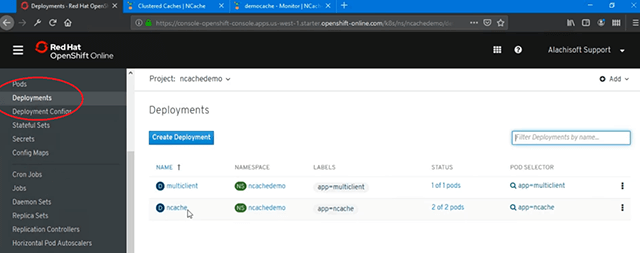

Ich habe ein Docker-Image, das eine .NET Core sowie Java-Anwendung, die in diesem Container ausgeführt wird. Ich habe also einen Container verwendet, um zwei verschiedene Anwendungen zu hosten, aber Sie können auch hier separate Container haben. Also, innerhalb meines gleichen Projekts, wenn ich hier klicke, habe ich NCache mit zwei Pods und wenn ich auf „Hinzufügen“ klicke und meine Client-Bereitstellung YAML importiere, kann ich fortfahren und dies erstellen, und dies würde automatisch einen separaten Container und eine separate Bereitstellung für meine Client-Anwendungen erstellen. Wenn ich auf Projekte zurückkomme und jetzt haben wir zwei verschiedene Bereitstellungen, wir haben „Multiclient“ mit 1 Pod und wir haben „ncache' mit 2 Pods, die wir als Teil davon gemacht haben NCache serverseitige Einrichtung.

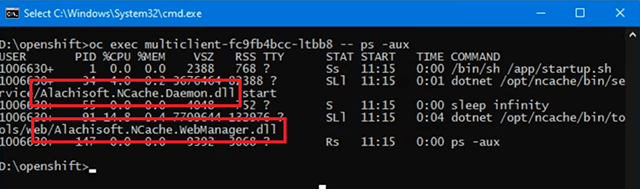

Wenn ich also zu den Pods gehe, habe ich erneut den Statuscontainer erstellt, und wenn ich diesen Befehl erneut ausführe, würde mir dies die Liste aller Pods zusammen mit ihren IP-Adressen geben. Früher hatten wir 236 und 206 und wir hatten jetzt auch 47 hinzugefügt, richtig. Das ist also der Client-Bereitstellungs-Pod und hier ist die ID davon. Wenn ich jetzt schnell nachsehe, ob derzeit Anwendungen in dieser Bereitstellung in diesem Pod ausgeführt werden, wenn ich diesen Befehl ganz schnell ausführe, würde ich nur die sehen NCache Service-Daemon, „startup.sh“ für diesen Container. Alachisoft.NCache.Daemon.dll beginnt mit NCache Service-Prozess und dass wir einen Web-Manager-Prozess haben.

Daher wird zu diesem Zeitpunkt keine Client-Anwendung innerhalb dieses Containers ausgeführt, und das ist dasselbe, was Sie auch von hier aus sehen können, wenn kein Client verbunden ist. Lassen Sie uns also fortfahren und eine Java-Anwendung in diesem Client ausführen. Ich werde das ausführen. Ich verwende den Namen des Caches, der "democache" ist, das ist der Name, um eine Verbindung herzustellen.

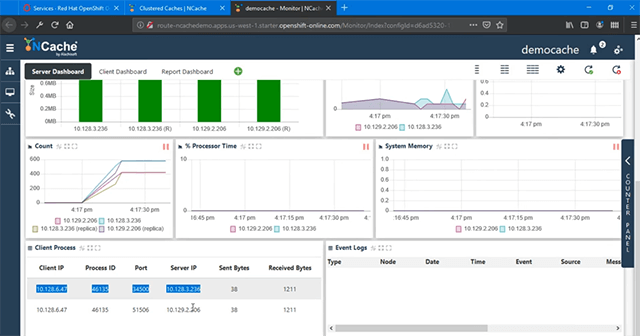

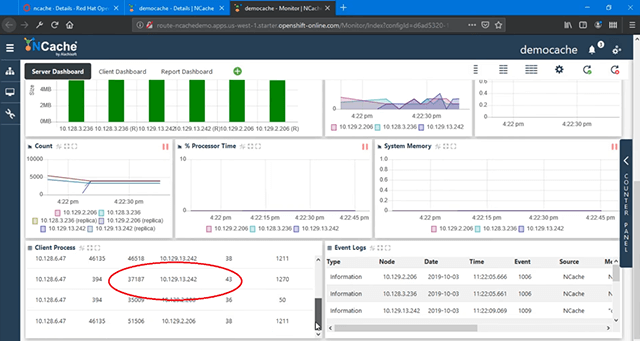

Ich brauche hier keine IP-Adressen, sondern den Headless-Dienst zur Erkennung. Denken Sie daran, dass wir einen Erkennungsdienst erstellt haben, also muss ich zurück zu „Dienste“ gehen, den Namen abrufen und der Name war „Cacheserver“ und er hatte die Portzuordnung von diesem Dienst zu allen zugrunde liegenden Pods. Mit NCache Client haben wir diese integrierte Logik, in der er mit diesem benannten Dienst kommuniziert und von diesem Dienst automatisch alle zugrunde liegenden Pods innerhalb der OpenShift Kubernetes-Plattform erkennt. Also, wenn ich den Namen dieses Dienstes angebe, unser NCache Der Client ist intelligent genug und würde sich automatisch verbinden und ein vollständig verbundenes Client-Server-Setup mit formulieren NCache Cluster. Diese Anwendung wird also jetzt ausgeführt, und wenn ich den Überwachungsaspekt davon zurückbringe, kann ich jetzt einen vollständig verbundenen Cluster mit einem hinzugefügten Client sehen, und Sie können bereits die Client-Aktivität sehen, die bei Hinzufügungen/Sek. angezeigt wird, und wir haben Aktivität innerhalb Konsole und wir können sehen, dass CRUD-Vorgänge auf meinem Cache-Cluster in OpenShift ausgeführt werden.

Wenn ich mir jetzt die Client-Prozesse ansehe, werden mir 47 IPs angezeigt, die sowohl mit 236 als auch mit 206 verbunden sind. Mit dem Headless-Dienst war die Erkennung also erfolgreich und es konnte eine Verbindung zu allen zugrunde liegenden Pods hergestellt werden Probleme.

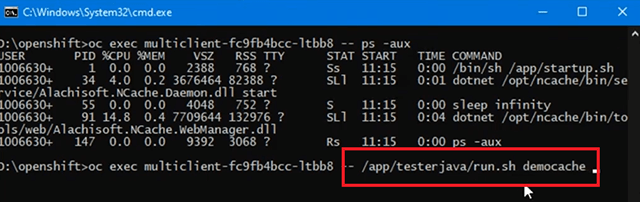

Richtig, also und Sie können auch sehen, dass die Überwachungs- und Verwaltungsaspekte auch absolut gut funktionieren. Wenn ich jetzt denselben Befehl noch einmal ausführe, zeige ich die laufenden Prozesse innerhalb dieser Client-Bereitstellung auf diesem Pod. Wenn ich das also kopiere, sollten Sie jetzt eine Java-Anwendung sehen, die verwendet wird NCache Als Teil davon läuft auch der Java-Client. Also anders als NCache Service im Web Manager, jetzt haben wir eine laufende Java-Anwendung, die diesen „Democache“ mit dem „Cacheserver“ als Serverparameter für die Verbindung verwendet.

So einfach ist es also, eine Java-Anwendung damit auszuführen NCache alles in Kubernetes mit OpenShift Platform.

Der nächste Schritt ist das Ausführen der .NET Core Anwendung und dafür würde ich einfach weitermachen und die ausführen .NET Core client, der Teil desselben Containers auf der Clientseite ist.

Die Schritte sind also für mich gleich, und wenn ich das sehr schnell mache, würde dies unsere starten .NET Core Client für die Verbindung mit NCache und wieder brauche ich 'democache' und 'cacheserver', das ist der Headless-Discovery-Service für die Verbindung zu zugrunde liegenden Pods. Der zweite Client würde also ausgeführt und Sie würden sehen, wie die Client-Prozesse dort zunehmen. Jetzt haben wir einen separaten Client-Prozess, mit dem wir verbunden sind NCache und wenn ich hierher zurückkomme, haben wir 2 Clients verbunden und wir haben alle Parameter, alle Zähler, die Aktivität anzeigen, was in seiner, Sie wissen schon, Kapazität richtig erhöht ist. Wir haben also mehr Additionen/Sekunde. Abrufe/Sekunde sind ebenfalls gestiegen.

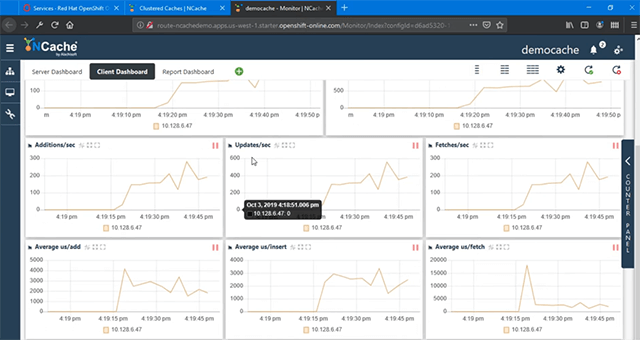

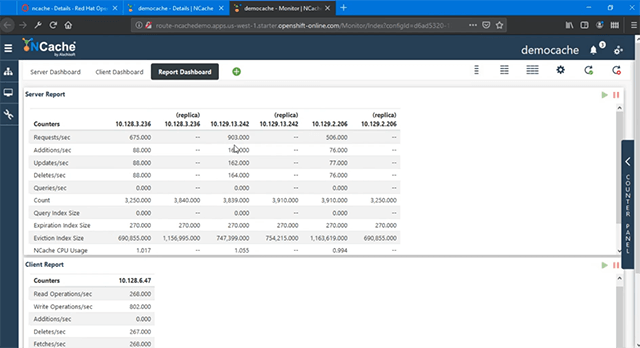

Updates/Sekunde haben zugenommen, richtig. Alle Werte werden also mit der neu hinzugefügten Last erhöht und Sie können das „Client Dashboard“ sehen, wo wir Clients haben, die alle Aktivitäten anzeigen.

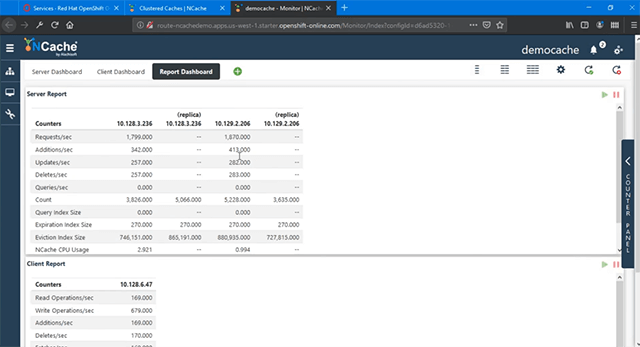

Damit NCache Verwaltung und Überwachung funktionieren auch für Client-Bereitstellungen absolut einwandfrei, Sie müssen nur die Ports öffnen, wie wir es für die getan haben NCache Server und hier ist eine Berichtsansicht derselben, in der wir serverseitige Zähler im Bericht haben und dann haben wir die clientseitigen Zähler von unseren Client-Bereitstellungs-Pods.

Skalieren NCache Cluster

Das nächste, was ich demonstrieren werde, ist „Skalieren Ihrer NCache Cache-Cluster' in OpenShift Platform. Dies wird Ihnen helfen, die Kapazität für die Bearbeitung von Anfragen zu erhöhen NCache und das auch zur Laufzeit.

Sehen wir uns an, wie das geht. Fügen Sie dieser Bereitstellung jetzt weitere Pods hinzu, um die Kapazität zu erhöhen. Ich gehe zu "Bereitstellungen".

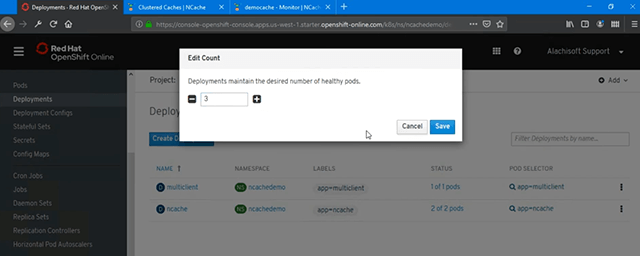

Es gibt mehrere Möglichkeiten, wie Sie dies tun können. Wie Sie derzeit sehen können, haben wir 2 Pods für NCache. Um also eine weitere Instanz hinzuzufügen, habe ich eine Option, um die Anzahl zu „bearbeiten“, sie auf 3 zu erhöhen, und dann „Speichern“, um dies und das automatisch zu erstellen. Das ist also das Einfachste.

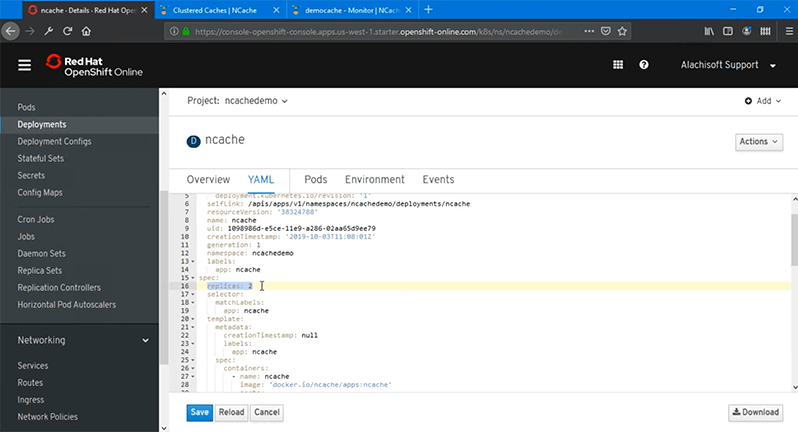

Eine andere Option besteht darin, dass Sie Ihre Bereitstellung „bearbeiten“ und Sie die YAML-Datei erhalten und die Anzahl der „Replikate“ erhöhen, die wir ursprünglich auf „2“ gesetzt haben, sie auf 3 erhöhen und sie dann neu laden, und das würde sie automatisch bereitstellen oder Speichern Sie es einfach, es würde einfach weitermachen und es tun.

Sie können auch die Befehlszeile verwenden, also werde ich dies jetzt verwenden und „Speichern“ wählen, und das sollte ausreichen, um einen weiteren Pod mit dem Docker-Container-Image zu erstellen, das ich habe, und jetzt sollte ich eine weitere Replik dieses Containers sehen erstellt und läuft vollständig. Es ist sehr schnell innerhalb von OpenShift und wenn ich die 'oc get pods' Befehl sollte ich sehen können, dass eine andere IP-Adresse hinzugefügt wurde, es ist 13.242. Ich habe also eine Client-Bereitstellung für vorhandene NCache Server-Pod-Bereitstellungen und dann habe ich innerhalb dieser Bereitstellung auch 242 hinzugefügt. Mein OpenShift-Pod ist also verfügbar, ich muss nur zur „Verwaltung“ zurückkehren und das dann auch in meinem Cache-Cluster hinzufügen, da Web Manager verfügbar ist. Also muss ich nur diese IP-Adresse kopieren, „Hinzufügen“ wählen und das erlaubt mir, diese IP hinzuzufügen und zu wählen, dass sie in den Cache hinzugefügt werden soll, los geht’s. Es wird hinzugefügt und wenn ich dann mit der rechten Maustaste klicke und „Start“ wähle, wird dies zur Laufzeit dem Cache-Cluster beitreten. Ich muss keine Client-Anwendungen unterbrechen, ich muss den laufenden Cache überhaupt nicht stoppen. Also, mein laufender Cache-Cluster ist diesem Knoten beigetreten, und los geht's, er hat auch bereits begonnen, Aktivitäten zu sehen, weil die Anwendungen immer noch ausgeführt wurden, also habe ich aktive und darin erstellte Sicherungen NCache Cluster und 242 ist dem Cache-Cluster vollständig beigetreten und nimmt an der Anfragebehandlung teil.

Meine Kapazität zur Bearbeitung von Anfragen wurde erhöht, da wir jetzt 3 Server haben, die den Cache in OpenShift hosten, anstatt 2. Es ist vollständig verbunden. Sie können Anfragen/Sek. sehen, 242 ist in allen Vorgängen verbunden und zeigt volle Aktivität, und wenn wir zu den „Client-Prozessen“ zurückkehren, sind diese auch mit 242 verbunden, weil sie wieder den Headless-Service für die Erkennung verwenden.

Was auch immer Sie innerhalb dieser Bereitstellung hinzufügen, dieser Service wird übereinstimmen, Sie kennen den Weg dafür. Wir haben also alle diese Server voll eingebunden und funktionieren absolut einwandfrei. So einfach ist es also, Ihren Cache-Cluster in OpenShift Platform zu skalieren, und mit Red Hat erhalten Sie die Unterstützung, die Sie nutzen können NCache als Teil davon.

Damit sind wir am Ende unseres Videos angelangt. Wir haben erfolgreich gezeigt, wie Sie bereitstellen können NCache in Red Hat OpenShift Platform und wie einfach es zu verwenden ist NCache aus Ihrem Java und .NET Core Anwendungen. Wir haben auch überprüft, wie effektiv Sie Ihre verwalten und überwachen können NCache Bereitstellungen in OpenShift. Ich hoffe, das war hilfreich. Bitte teilen Sie uns Ihr Feedback oder Ihre Fragen unter Alachisoft Support support@alachisoft.com. Vielen Dank!